Kto wynalazł pierwszy komputer na świecie? To pytanie budzi wiele emocji i kontrowersji w świecie technologii. Głównymi kandydatami na twórców pierwszego komputera są amerykańscy naukowcy J.P. Eckert i J.W. Mauchly, którzy stworzyli maszynę ENIAC podczas II wojny światowej. Jednakże inne wynalazki, takie jak Atanasoff-Berry Computer (ABC) oraz niemiecki Z3, również pretendują do tytułu "pierwszego komputera". W artykule przyjrzymy się tym wynalazcom oraz ich osiągnięciom, aby lepiej zrozumieć, jak rozwijała się technologia komputerowa.

Oprócz tego, omówimy kontrowersje związane z definicją komputera oraz to, jak różne interpretacje wpływają na tytuł "pierwszego komputera". Wreszcie, przyjrzymy się kluczowym innowacjom, które zrewolucjonizowały świat komputerów oraz wpływowi wojen na rozwój tej technologii.

Najważniejsze informacje:

- J.P. Eckert i J.W. Mauchly stworzyli ENIAC, pierwszy komputer ogólnego przeznaczenia.

- Atanasoff-Berry Computer (ABC) uznawany jest za pierwszy komputer cyfrowy, mimo że nie był pełnoprawnym komputerem.

- Konrad Zuse zaprojektował Z3, pierwszą programowalną maszynę cyfrową, która spełniała warunki "kompletności Turinga".

- Wielka Brytania zbudowała maszynę Colossus, która była używana do łamania szyfrów podczas II wojny światowej.

- Różne definicje komputera wpływają na to, kto może być uznawany za jego wynalazcę.

Kto wynalazł pierwszy komputer? Przegląd historyczny i kontekst

Za głównych konstruktorów pierwszego komputera na świecie uznawani są amerykańscy naukowcy J.P. Eckert i J.W. Mauchly. Opracowali oni maszynę ENIAC na zlecenie armii amerykańskiej w czasie II wojny światowej. ENIAC, czyli Elektroniczna Liczba Maszynowa, był pierwszym komputerem ogólnego przeznaczenia, który zrewolucjonizował sposób przetwarzania danych. Jego uruchomienie miało miejsce w 1946 roku, a jego możliwości były ogromne jak na ówczesne czasy.

Jednak historia komputerów nie kończy się na ENIAC. Warto wspomnieć o innych kluczowych wynalazcach, takich jak John Atanasoff i Clifford Berry, którzy stworzyli Atanasoff-Berry Computer (ABC) w 1939 roku. Choć ABC nie był pełnoprawnym komputerem w dzisiejszym rozumieniu, to jego innowacje miały ogromny wpływ na przyszłe konstrukcje. Również niemiecki inżynier Konrad Zuse zaprojektował Z3 w 1941 roku, co czyni go jednym z pierwszych programowalnych komputerów. Te wynalazki pokazują, jak różnorodne były podejścia do tworzenia komputerów w pierwszych latach ich istnienia.

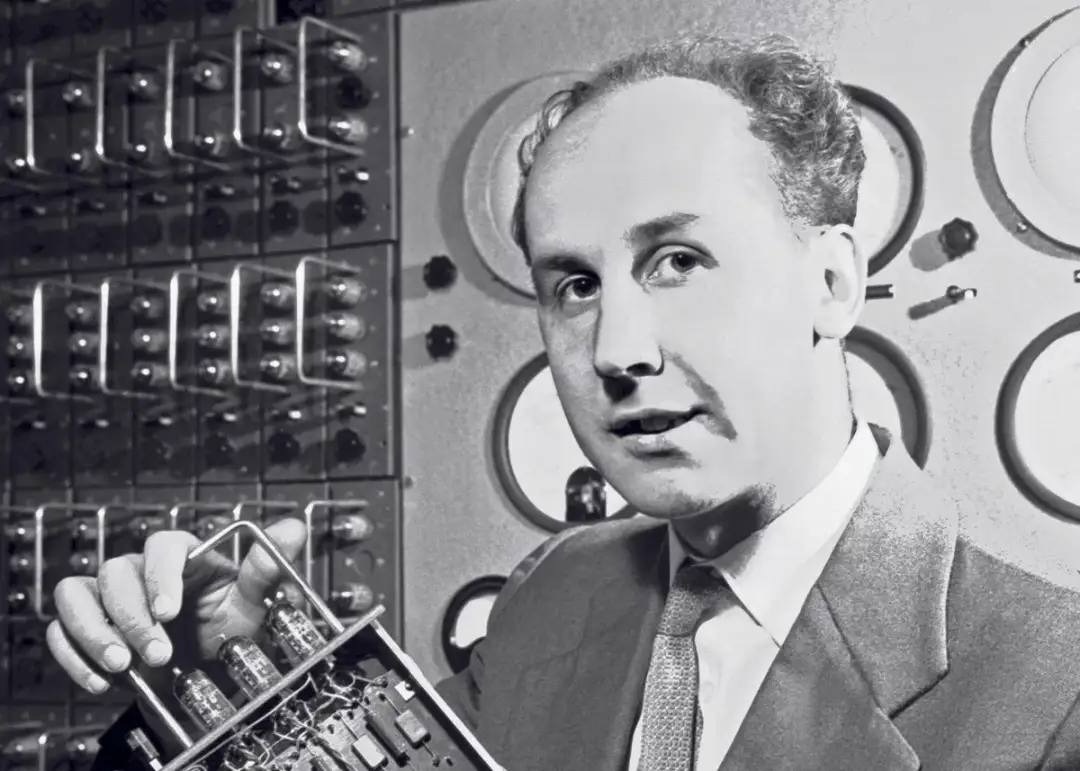

J.P. Eckert i J.W. Mauchly: Twórcy ENIAC i ich wpływ

J.P. Eckert i J.W. Mauchly są uważani za pionierów w dziedzinie komputerów dzięki stworzeniu ENIAC. Ta maszyna, zbudowana w latach 1943-1945, była pierwszym komputerem, który mógł być programowany do różnych zadań. ENIAC miał 18 000 lamp elektronowych i zajmował pomieszczenie o powierzchni 167 m². Jego zdolność do wykonywania skomplikowanych obliczeń w krótkim czasie miała ogromny wpływ na rozwój technologii komputerowej, a także na różne dziedziny nauki i przemysłu.

ENIAC był w stanie wykonywać do 5 000 operacji na sekundę, co w tamtych czasach było rewolucyjnym osiągnięciem. Jego znaczenie polegało nie tylko na wydajności, ale także na tym, że otworzył drzwi do dalszych badań i rozwoju komputerów. Wprowadzenie programowalności w komputerach pozwoliło na ich zastosowanie w różnych dziedzinach, od nauki po przemysł, i stało się fundamentem dla przyszłych komputerów.

John Atanasoff i Clifford Berry: Pionierzy komputerów cyfrowych

John Atanasoff i Clifford Berry są uznawani za twórców Atanasoff-Berry Computer (ABC), który powstał w 1939 roku. ABC był pierwszym komputerem cyfrowym, który wykorzystywał elektroniczne lampy próżniowe do obliczeń. Choć nie był on w pełni funkcjonalnym komputerem w dzisiejszym rozumieniu, jego innowacje, takie jak zastosowanie binarnego systemu liczenia, miały ogromny wpływ na rozwój przyszłych technologii komputerowych. Dzięki tym pionierskim pracom, Atanasoff i Berry przyczynili się do kształtowania podstaw komputerów, jakie znamy dziś.

Warto zaznaczyć, że ABC był zaprojektowany głównie do rozwiązywania równań różniczkowych, co czyniło go wyjątkowym jak na tamte czasy. Chociaż projekt ABC nie został zrealizowany w pełni z powodu braku funduszy i problemów technicznych, jego koncepcje stały się fundamentem dla późniejszych komputerów. Prace Atanasoffa i Berry'ego były przełomowe i wyznaczyły kierunek dla kolejnych wynalazców, którzy rozwijali ideę komputerów cyfrowych.

Konrad Zuse: Z3 jako pierwsza programowalna maszyna

Konrad Zuse był niemieckim inżynierem, który w 1941 roku zaprezentował Z3, uznawany za pierwszą w pełni funkcjonalną i programowalną maszynę cyfrową. Z3 wykorzystywał mechaniczne przekaźniki do realizacji obliczeń, co było nowatorskim rozwiązaniem w tamtych czasach. Jego konstrukcja była oparta na binarnym systemie liczbowym, co pozwoliło na bardziej efektywne przetwarzanie danych. Z3 mogła być programowana za pomocą kart perforowanych, co znacznie ułatwiało użytkowanie w porównaniu do wcześniejszych maszyn.

Znaczenie Z3 w historii komputerów jest nie do przecenienia. Pomimo zniszczenia podczas II wojny światowej, jej rekonstrukcja potwierdziła, że spełniała warunki "kompletności Turinga", co oznacza, że mogła wykonywać dowolne obliczenia, które można zdefiniować algorytmicznie. Zuse, dzięki swoim innowacjom, przyczynił się do rozwoju technologii komputerowej, a jego prace stały się inspiracją dla kolejnych pokoleń inżynierów i programistów.

Kontrowersje dotyczące tytułu "pierwszego komputera"

Debaty na temat tego, kto wynalazł pierwszy komputer na świecie, są złożone i często kontrowersyjne. Różne definicje tego, co stanowi komputer, wpływają na to, kto może być uznawany za jego wynalazcę. Na przykład, niektórzy uważają, że komputer musi być programowalny, podczas gdy inni mogą definiować komputer jako urządzenie zdolne do wykonywania obliczeń. Takie różnice w definicjach prowadzą do nieporozumień i sporów wśród historyków technologii.

Ważne jest, aby zrozumieć, że różne definicje komputera mogą wpływać na naszą percepcję jego rozwoju. Na przykład, jeśli weźmiemy pod uwagę tylko komputery programowalne, to Z3 Konrada Zusego może być uznawany za pierwszy komputer. Z drugiej strony, jeśli spojrzymy na urządzenia, które były w stanie wykonywać obliczenia, to Atanasoff-Berry Computer (ABC) również ma swoje miejsce w tej dyskusji. W rezultacie, tytuł "pierwszego komputera" może być różnie interpretowany w zależności od przyjętej definicji.

Różne definicje komputera i ich znaczenie

Definicje komputerów są kluczowe w dyskusji o tym, kto był twórcą pierwszego komputera na świecie. Komputer można zdefiniować jako urządzenie, które przetwarza dane według ustalonych instrukcji. Współczesne komputery są programowalne, co oznacza, że można je dostosować do różnych zadań. Jednak w przeszłości wiele urządzeń, które dziś uznawane są za komputery, nie spełniało tych kryteriów. Dlatego różnice w definicjach mogą prowadzić do różnych wniosków na temat tego, kto stworzył pierwszy komputer.

Porównanie osiągnięć różnych wynalazców w kontekście

Osiągnięcia różnych wynalazców komputerów są niezwykle zróżnicowane i każda z ich konstrukcji wnosi coś unikalnego do historii technologii. J.P. Eckert i J.W. Mauchly stworzyli ENIAC, pierwszy komputer ogólnego przeznaczenia, który zrewolucjonizował obliczenia dzięki swojej programowalności i wydajności. Z kolei John Atanasoff i Clifford Berry zaprojektowali Atanasoff-Berry Computer (ABC), który był pionierski w zastosowaniu binarnego systemu liczenia, mimo że nie był pełnoprawnym komputerem. Konrad Zuse zbudował Z3, pierwszą programowalną maszynę cyfrową, która potrafiła wykonywać różnorodne obliczenia, a jej konstrukcja opierała się na mechanicznych przekaźnikach. Warto również wspomnieć o Colossusie, zaprojektowanym przez Tommy'ego Flowersa i Alana Turinga, który był kluczowy w łamaniu szyfrów podczas II wojny światowej i przyczynił się do rozwoju komputerów elektronicznych.

| Wynalazca | Komputer | Rok | Kluczowe cechy |

|---|---|---|---|

| J.P. Eckert i J.W. Mauchly | ENIAC | 1946 | Programowalny, pierwszy komputer ogólnego przeznaczenia |

| John Atanasoff i Clifford Berry | Atanasoff-Berry Computer (ABC) | 1939 | Używał binarnego systemu liczenia, nie był pełnoprawnym komputerem |

| Konrad Zuse | Z3 | 1941 | Pierwsza programowalna maszyna cyfrowa, oparta na przekaźnikach |

| Tommy Flowers i Alan Turing | Colossus | 1943 | Programowalny komputer używany do łamania szyfrów |

Czytaj więcej: Pierwszy na świecie przeszczep serca: przełom w medycynie, który zmienił życie

Jak rozwijała się technologia komputerowa po pierwszych wynalazkach

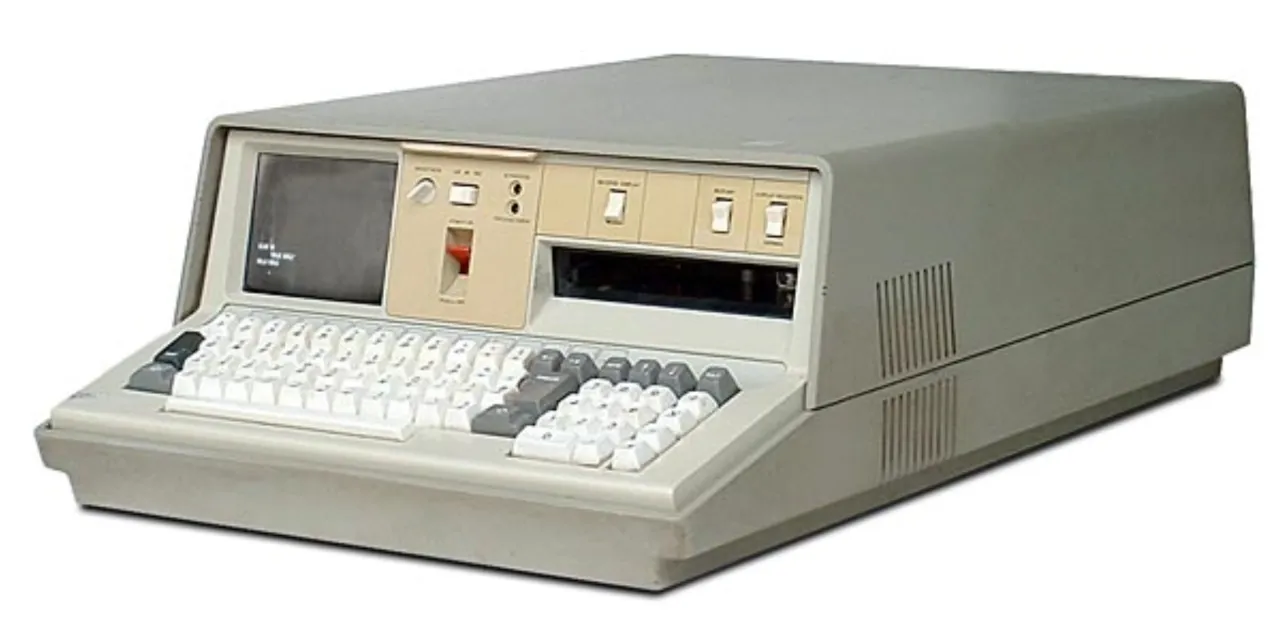

Po powstaniu pierwszych komputerów, takich jak ENIAC, ABC i Z3, technologia komputerowa zaczęła się dynamicznie rozwijać. Wprowadzenie tranzystorów w latach 50. XX wieku zrewolucjonizowało branżę, umożliwiając budowę mniejszych, tańszych i bardziej wydajnych komputerów. Tranzystory zastąpiły lampy próżniowe, co pozwoliło na zwiększenie niezawodności i zmniejszenie rozmiarów urządzeń. Wraz z rozwojem technologii mikroprocesorowej w latach 70. pojawiły się komputery osobiste, które zrewolucjonizowały sposób, w jaki ludzie korzystali z technologii.

W miarę jak komputery stawały się coraz bardziej dostępne, ich zastosowanie zaczęło obejmować różnorodne dziedziny, od przemysłu po edukację. Internet, który stał się powszechny w latach 90., otworzył nowe możliwości dla komputerów, umożliwiając globalną komunikację i wymianę informacji. Współczesne komputery są nie tylko szybkie, ale także inteligentne, z rozwojem sztucznej inteligencji i uczenia maszynowego, które zmieniają sposób, w jaki przetwarzamy i analizujemy dane. Technologia komputerowa wciąż się rozwija, a przyszłość niesie ze sobą jeszcze więcej innowacji.

Kluczowe innowacje i ich wpływ na przyszłość komputerów

Po wprowadzeniu pierwszych komputerów, takich jak ENIAC czy ABC, technologia komputerowa przeszła szereg kluczowych innowacji, które miały ogromny wpływ na jej przyszłość. Tranzystory, wprowadzone w latach 50. XX wieku, zrewolucjonizowały konstrukcję komputerów, umożliwiając budowę mniejszych, bardziej wydajnych i mniej awaryjnych urządzeń. Zastąpiły one lampy próżniowe, co pozwoliło na znaczne zmniejszenie rozmiarów komputerów oraz zwiększenie ich niezawodności. Kolejnym przełomem były układy scalone, które pozwoliły na umieszczenie wielu tranzystorów na jednym chipie, co z kolei przyczyniło się do dalszej miniaturyzacji i wzrostu wydajności komputerów.

W miarę jak technologia ewoluowała, pojawiły się również mikroprocesory, które zrewolucjonizowały rynek komputerów osobistych w latach 70. i 80. Dzięki nim komputery stały się bardziej dostępne dla szerokiego grona użytkowników, co przyczyniło się do rozwoju branży IT i powstania nowych aplikacji. Współczesne innowacje, takie jak sztuczna inteligencja i uczenie maszynowe, otwierają nowe możliwości w zakresie analizy danych i automatyzacji, co zmienia sposób, w jaki korzystamy z technologii komputerowej w codziennym życiu.

Wpływ wojen na rozwój technologii komputerowej

Wojny miały znaczący wpływ na rozwój technologii komputerowej, zarówno w zakresie finansowania, jak i badań. II wojna światowa przyczyniła się do intensyfikacji prac nad komputerami, gdyż armie potrzebowały nowoczesnych narzędzi do obliczeń balistycznych, szyfrowania i analizy danych. Wiele innowacji, które pojawiły się w tym okresie, było wynikiem pilnych potrzeb militarnych. Przykładem może być maszyna Colossus, która została stworzona do łamania niemieckich kodów, a jej rozwój przyczynił się do postępu w dziedzinie komputerów elektronicznych.

Po wojnie, wiele technologii opracowanych na potrzeby militarnych projektów zostało zaadoptowanych przez przemysł cywilny, co przyspieszyło rozwój komputerów. Wsparcie rządowe dla badań i rozwoju w dziedzinie technologii komputerowej miało również kluczowe znaczenie dla powstania nowoczesnych systemów komputerowych. Współczesne konflikty zbrojne wciąż wpływają na rozwój technologii, prowadząc do innowacji w dziedzinie komunikacji, analizy danych i sztucznej inteligencji.

Jak nowoczesne komputery kształtują przyszłość pracy i życia

W miarę jak technologia komputerowa rozwija się, nowoczesne komputery stają się kluczowym elementem nie tylko w przemyśle, ale także w codziennym życiu. Przykładem jest automatyzacja procesów w różnych branżach, która pozwala na zwiększenie efektywności i redukcję kosztów. Dzięki zastosowaniu sztucznej inteligencji i uczenia maszynowego, firmy mogą analizować ogromne zbiory danych, co umożliwia podejmowanie lepszych decyzji biznesowych oraz przewidywanie trendów rynkowych. W przyszłości możemy spodziewać się jeszcze większej integracji technologii komputerowej w życie codzienne, co może prowadzić do powstania inteligentnych domów i miast.

Również w obszarze edukacji technologia komputerowa odgrywa coraz większą rolę. E-learning i platformy edukacyjne wykorzystujące interaktywne technologie stają się normą, umożliwiając dostęp do wiedzy dla osób na całym świecie. Takie podejście nie tylko zwiększa dostępność edukacji, ale także dostosowuje proces nauczania do indywidualnych potrzeb uczniów. W miarę jak technologia będzie się rozwijać, możemy oczekiwać dalszego wzrostu znaczenia komputerów w różnych aspektach życia, co otworzy nowe możliwości zarówno dla jednostek, jak i całych społeczności.